반응형

250x250

Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | |||||

| 3 | 4 | 5 | 6 | 7 | 8 | 9 |

| 10 | 11 | 12 | 13 | 14 | 15 | 16 |

| 17 | 18 | 19 | 20 | 21 | 22 | 23 |

| 24 | 25 | 26 | 27 | 28 | 29 | 30 |

Tags

- 로지스틱회귀

- 코딩독학

- 유학생

- Seaborn

- SQL

- 행렬

- 코드잇TIL

- 다항회귀

- 코드잇

- 코딩공부

- 런던

- 오늘도코드잇

- 나혼자코딩

- 코드잇 TIL

- 경사하강법

- HTML

- numpy

- 판다스

- for반복문

- 머신러닝

- CSS

- 파이썬

- 데이터분석

- 결정트리

- 코딩

- 윈도우함수

- 선형회귀

- sql연습문제

- 영국석사

- matplotlib

Archives

- Today

- Total

영국 척척석사 유학생 일기장👩🏻🎓

(Machine Learning) 경사 하강법 계산 본문

728x90

반응형

경사 하강법을 이용하여 업데이트 하는 방법에 대해 알아보겠습니다.

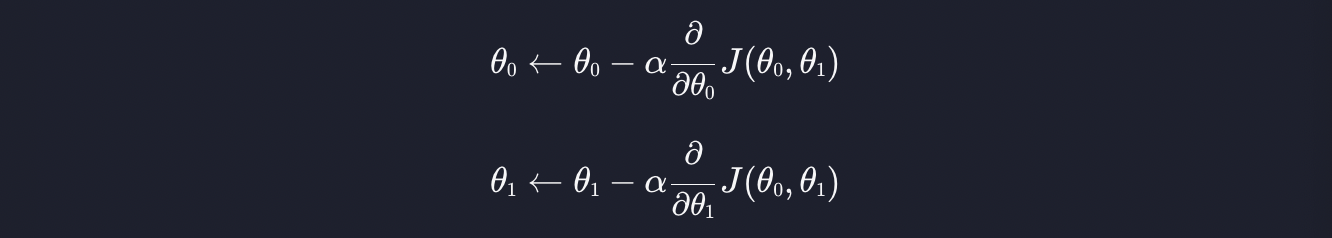

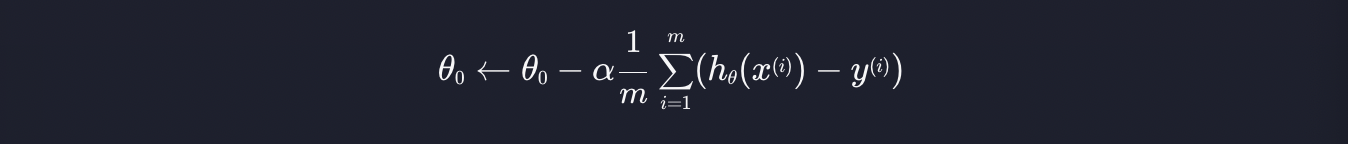

세타제로와 세타원을 업데이트 하는 방법은 다음과 같습니다.

1. 세타0 업데이트

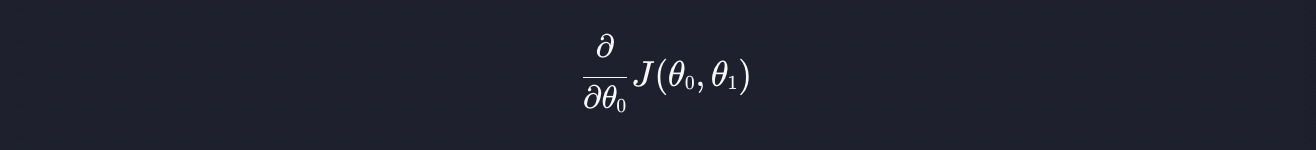

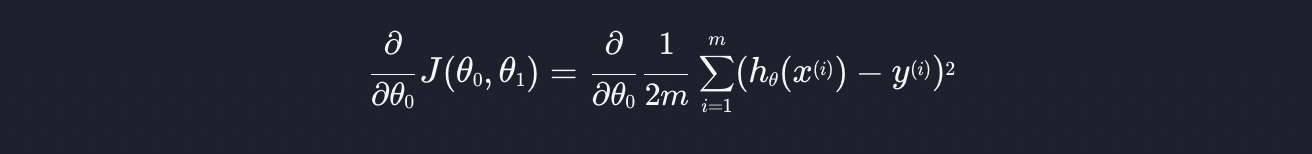

편미분을 하는 부분을 살펴봅시다.

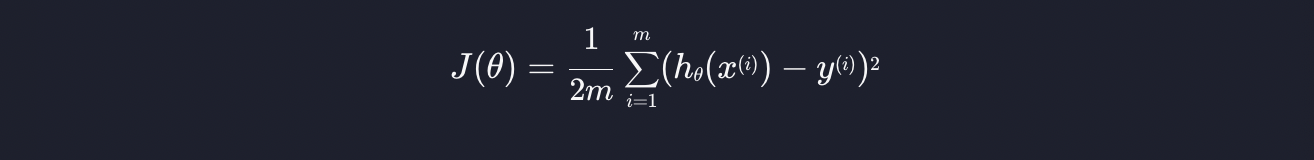

여기 손실 함수 J가 있는데, 선형 회귀에서 우리의 손실 함수 J는 아래와 같습니다.

편미분 식에 대입하면 아래와 같습니다.

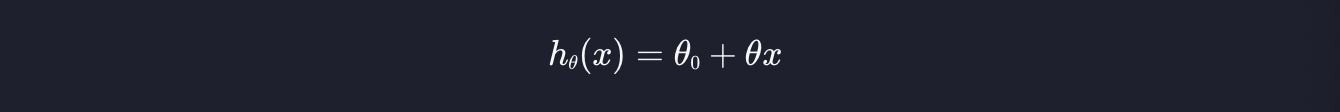

여기에 가설 함수 h는 다음과 같습니다.

이것을 위식에 대입하면

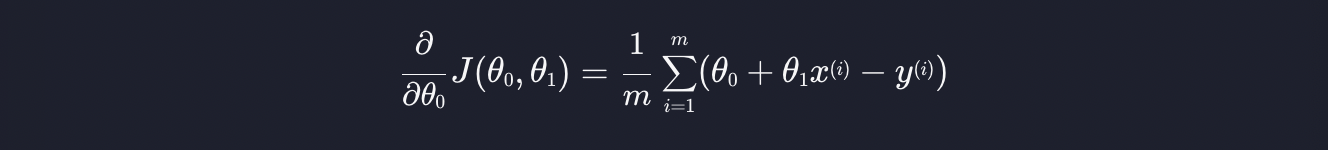

이걸 이제 세타0에 대해 편미분하면 아래와 같습니다.

가설 함수 h로 다시 돌려줍니다.

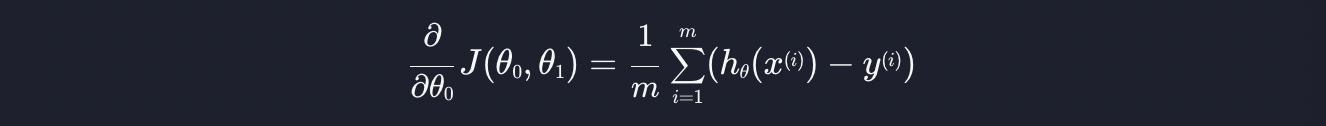

결국 편미분은 아래와 같이 나오는데 이걸 세타0을 업데이트 하는 기존 공식에 대입하면 됩니다.

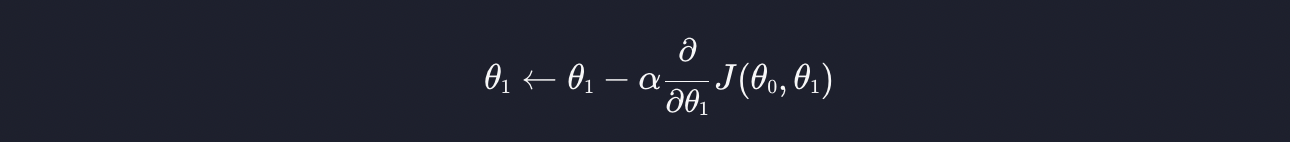

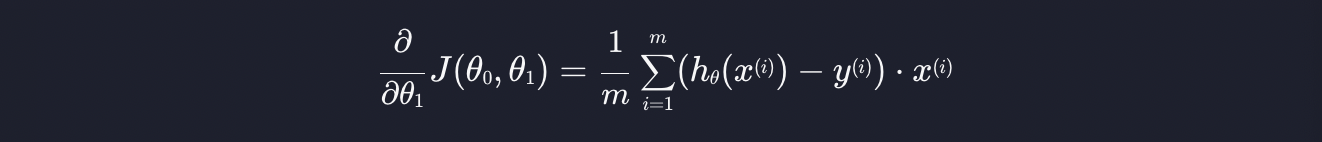

2. 세타1 업데이트

세타1을 업데이트 하는 공식을 살펴봅시다.

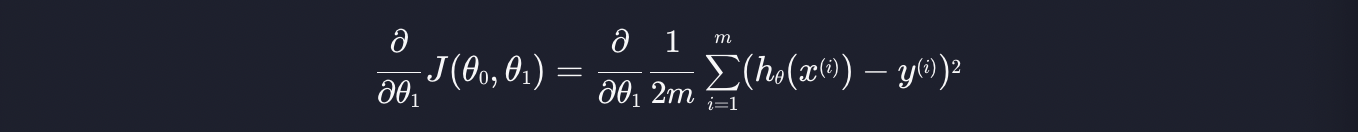

편미분 하는 부분을 집중적으로 알아봅시다. 편미분 식에 손실 함수 J를 대입하면 아래와 같습니다.

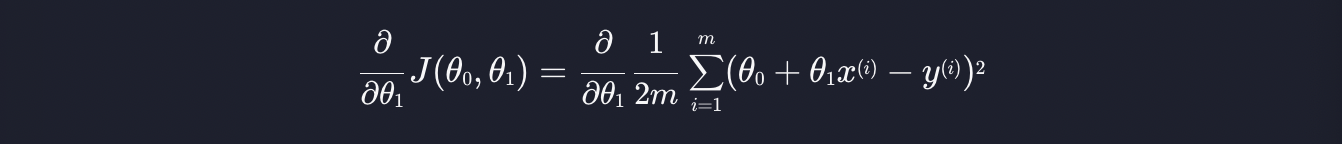

가설 함수 h를 대입합니다.

이제 세타1에 대해 편미분을 하면 다음과 같이 나옵니다.

이 부분에서 가설 함수 h와 같은 부분은 다시 돌려줍니다.

결국 편미분 한 식을 세타1을 업데이트하는 기존 공식에 대입하면 됩니다.

위 두가지를 이용해서 세타0과 세타1을 반복적으로 업데이트 하면, 결국에는 손실을 최소화하는 최적선을 구해낼 수 있습니다.

728x90

반응형

'코딩공부 > Machine Learning' 카테고리의 다른 글

| (Machine Learning) 학습률 알파 (0) | 2023.08.09 |

|---|---|

| (Machine Learning) 선형 경사 하강법 구현하기 (0) | 2023.07.12 |

| (Machine Learning) 손실 함수 (loss function) (0) | 2023.07.11 |

| (Machine Learning) 평균 제곱 오차 (MSE) (0) | 2023.07.10 |

| (Machine Learning) 선형 회귀 가설 함수 (0) | 2023.07.10 |